Das Sourccey-Team hat sich eine brutale Challenge gestellt. 24 Stunden Zeit, um einen kompletten Roboter zu bauen und ihn mit KI zu trainieren, ein Handtuch zu falten. Dieser Roboter ist aber nicht für sie selbst, sondern für ihren ersten zahlenden Kunden.

Der Bauplan unter Zeitdruck

Die Strategie war klar. Tagsüber den Roboter zusammenbauen, nachts das KI-Modell trainieren lassen. Das Modell braucht etwa zehn Stunden Trainingszeit auf ihren 5090 GPUs, was dem Team theoretisch 14 Stunden für die Hardware lässt. In der Praxis wurde es deutlich knapper.

Nick verkabelte zuerst die Radmotoren. Ein kritischer Schritt, weil Fehler hier später unter dem gesamten Roboter begraben werden und schwer zu finden sind. Miles und Chris übernahmen parallel die Arme, die nach wie vor der heikelste Teil sind. Jeder Motor muss millimetergenau ausgerichtet werden, kleine Fehler multiplizieren sich durch die Kinematik.

Probleme, die fast alles verzögert hätten

Schon früh lief einiges schief. Ein Motor hatte keinen Clip, was bedeutete, dass der komplette Motorhalter auseinandergenommen und ein neuer Motor eingelötet werden musste. Beim Druck des Bizeps-Teils hatten sie versehentlich die falsche Version gewählt, was weitere drei Stunden Druckzeit kostete.

Dann kam der nächste Schock. Die Kameraleute mussten früher weg als geplant, weil der Verkehr in LA brutal ist. Statt der ursprünglichen 14 Stunden schrumpfte die verfügbare Bauzeit auf etwa acht. Was normalerweise drei Tage dauert, mussten sie jetzt in weniger als einem schaffen.

Die Infrastruktur dahinter

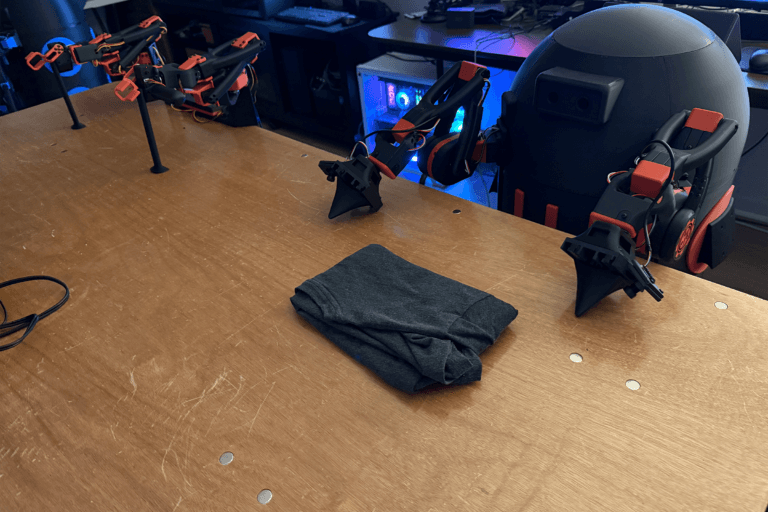

Colin baute den Z-Aktuator, quasi die Wirbelsäule des Roboters. Dieser lässt die Arme nach oben und unten fahren, damit der Roboter sowohl Objekte vom Boden als auch von Tischen greifen kann. Das Problem bei dieser Komponente ist, dass alles andere darauf aufbaut. Wenn hier etwas falsch läuft, muss der komplette Roboter wieder auseinander.

Die Elektrik ist der gefährlichste Teil. Jedes Kabel muss exakt sitzen. Ein Fehler kann jede elektrische Komponente auf dem Board zerstören. Sie verwenden einen 12V 10Ah Lithium-Eisenphosphat-Akku, der sicherer ist als normale Lithium-Ionen-Batterien und länger geladen werden kann. Er ist zwar größer, aber bei einem Roboter spielt das keine Rolle.

Interessant fand ich die Bemerkung, dass sie das PCB-Design über mehrere Monate selbst entwickelt haben, obwohl keiner von ihnen vorher Erfahrung damit hatte. ChatGPT und Datenblätter waren ihre Lehrer.

Der Moment der Wahrheit

Nach hektischen letzten 30 Minuten, in denen Kuppel, Z-Aktuator und Arme dran mussten, war das Chassis fertig. Die Hardware war komplett, mit vier Stunden Puffer bis Mitternacht, als das KI-Training starten musste.

Ein kurzer Schreckmoment noch: Der Raspberry Pi schien nicht zu funktionieren. Grünes Licht, aber kein Boot. Die Lösung war fast schon komisch, das PCI-Kabel war falsch herum eingesteckt. Das Training lief dann über Nacht. Am nächsten Tag der Test.

Das Ergebnis

In unter 24 Stunden von Null zum fertigen, funktionierenden R2-D2 Roboter. Das ist ihre bisher schnellste Zeit. Was vorher zwei Tage für das Chassis brauchte, schafften sie jetzt in einem.

Weitere Artikel zu Sourccey

Vorheriger XONOID Artikel: R2-D2 für unter 1.000 Dollar

Erster XONOID Artikel: Der Open-Source Heimroboter für jedermann