Galaxea Dynamics hat sein G0Plus VLA-Modell als Open Source veröffentlicht, inklusive einer „Pick Up Anything“-Demo, die ohne spezielles Training funktioniert. Ein Roboter soll Dinge greifen können, die er noch nie zuvor gesehen hat und zwar allein auf Basis einer Sprachaufforderung.

„Pick up the red cup.“

Kein Training. Kein Finetuning. Kein Objektprofil.

Vision-Language-Action, kurz VLA, ist im Kern der Versuch, Robotik aus der Endlosschleife des Nachtrainierens zu befreien. Klassische Systeme funktionieren gut solange sie exakt das tun, wofür sie trainiert wurden. Eine neue Tasse, ein anderes Glas, eine leicht veränderte Umgebung, und das System fällt zurück auf Trial-and-Error.

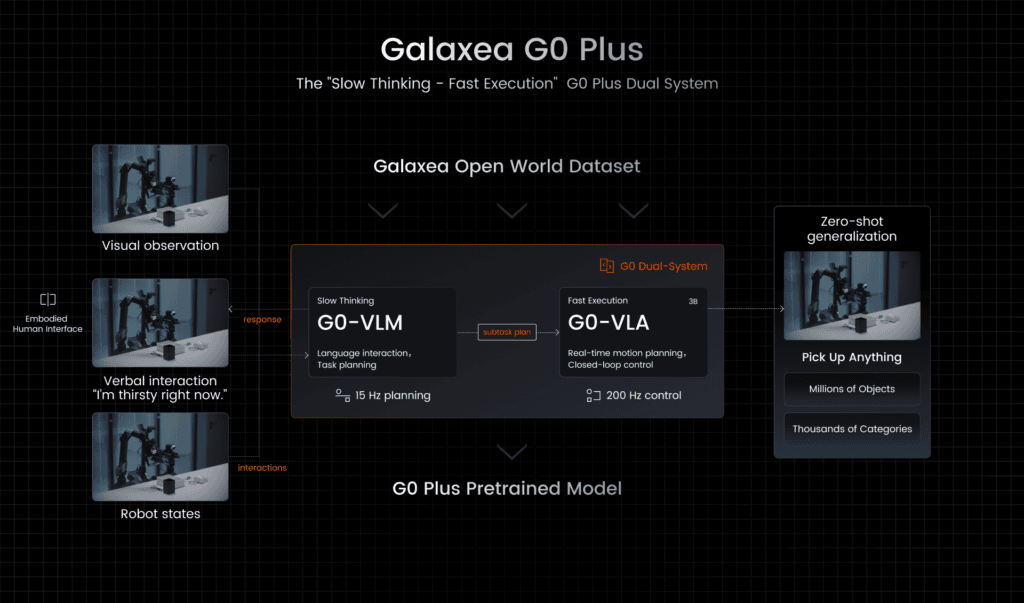

Galaxea geht einen anderen Weg. G0Plus kombiniert visuelle Wahrnehmung, natürliche Sprache und motorische Aktionen in einem Modell. Der Roboter bekommt ein Kamerabild, hört eine Anweisung und berechnet daraus direkt eine Handlung. Entscheidend ist dabei der Zero-Shot-Ansatz: Das Modell soll nicht lernen was ein Objekt ist, sondern wie es sich in einer Szene verhält. Das ist der Unterschied zwischen Erkennen und Verstehen

Kein Paper, sondern ein laufendes System

Bemerkenswert ist nicht nur das Modell selbst, sondern die Art der Veröffentlichung. Galaxea stellt nicht einfach Gewichte ins Netz, sondern liefert einen direkt einsetzbaren Checkpoint für Greifaufgaben mit. Dazu kommt eine „Pick Up Anything“-Demo, die sich per Docker sofort testen lässt.

G0Plus_3B_base – ein vortrainiertes Vision-Language-Action-Modell als Basis für eigenes Fine-Tuning

G0Plus_3B_base-pick_and_place – ein sofort einsetzbarer Checkpoint für Greifaufgaben

„Pick Up Anything“-Demo – inklusive Dockerfile und Anleitung, um das System direkt auf echter Hardware oder in der Simulation zu testen

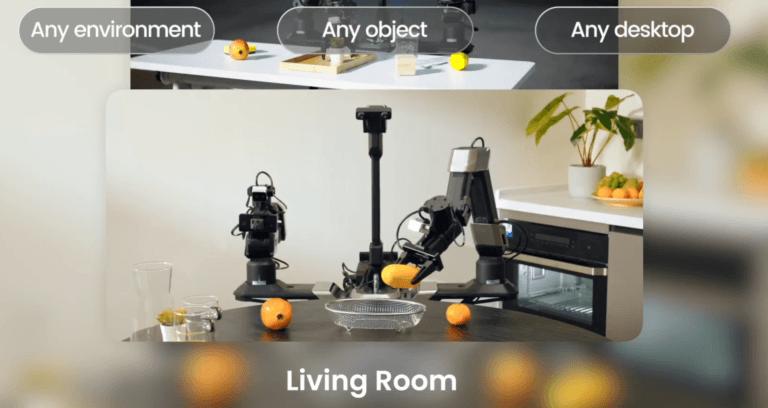

Galaxea bezeichnet den Checkpoint explizit als „deployment-ready“. Das ist eine starke Behauptung, denn viele Robotik-Modelle funktionieren hervorragend im Labor und scheitern im Alltag. Der Unterschied hier ist, dass G0Plus auf echter Hardware trainiert wurde, nicht ausschließlich in der Simulation.

Die Grundlage für G0Plus ist ein eigener Open-World-Datensatz, den Galaxea bereits im Herbst 2025 veröffentlicht hat. Statt synthetischer Szenen setzt das Team auf reale Umgebungen wie Wohnungen, Küchen, Büros und Einzelhandel. Menschen führen Aufgaben aus, der Roboter beobachtet, Aktionen werden in Sprache zerlegt und annotiert.

Der Datensatz dahinter

Grundlage des Modells ist der Galaxea Open-World Dataset, der bereits im September 2025 veröffentlicht wurde.

- Über 500 Stunden realer Manipulationsdaten

- Einheitliche Roboterplattform für konsistente Daten

- Szenarien aus Wohnungen, Küchen, Einzelhandel und Büros

- Sprachbasierte Subtask-Annotationen

- Kompatibel mit RLDS und LeRobot

Autonomes Fahren als Denkmodell

Dass Galaxea diesen Weg geht, ist kein Zufall. Das Führungsteam kommt aus dem autonomen Fahren, unter anderem von Waymo und Momenta. Dort hat man gelernt, dass Wahrnehmung, Entscheidungsfindung und Aktion nicht getrennt optimiert werden dürfen.

Galaxea baut diese Brücke bewusst. Das Unternehmen entwickelt nicht nur Modelle, sondern auch eigene Roboterplattformen. Der wheeled Humanoid R1 ist bereits im Einsatz, ein bipedaler Humanoid soll 2026 folgen. G0Plus ist also kein losgelöstes Forschungsprojekt, sondern Teil eines Produkt-Stacks.

Quelle