Was Embodied AI eigentlich bedeutet

Embodied AI beschreibt künstliche Intelligenz, die in einem physischen Körper existiert und mit der realen Welt interagiert. Der Begriff kommt aus der Kognitionswissenschaft, wo „Embodied Cognition” die These vertritt, dass Intelligenz nicht nur im Gehirn sitzt, sondern untrennbar mit dem Körper und seiner Umgebung verbunden ist.

Ein Kleinkind lernt nicht, was „schwer” bedeutet, indem es eine Definition liest. Es lernt, indem es Dinge hochhebt, fallen lässt und wieder aufhebt. Diese Art von Wissen, sogenanntes „grounded knowledge”, entsteht nur durch physische Erfahrung. Genau das fehlt klassischen KI-Systemen.

Large Language Models wie GPT-4 oder Claude manipulieren Symbole. Sie wissen statistisch, dass „Glas” und „zerbrechlich” oft zusammen vorkommen. Aber sie haben nie erlebt, wie sich Glas anfühlt, wie es klingt, wenn es zerbricht, oder wie viel Kraft nötig ist, es zu halten. Das nennt man in der KI-Forschung das „Grounding Problem”: Symbole ohne Verbindung zur physischen Realität.

Woher der Begriff kommt

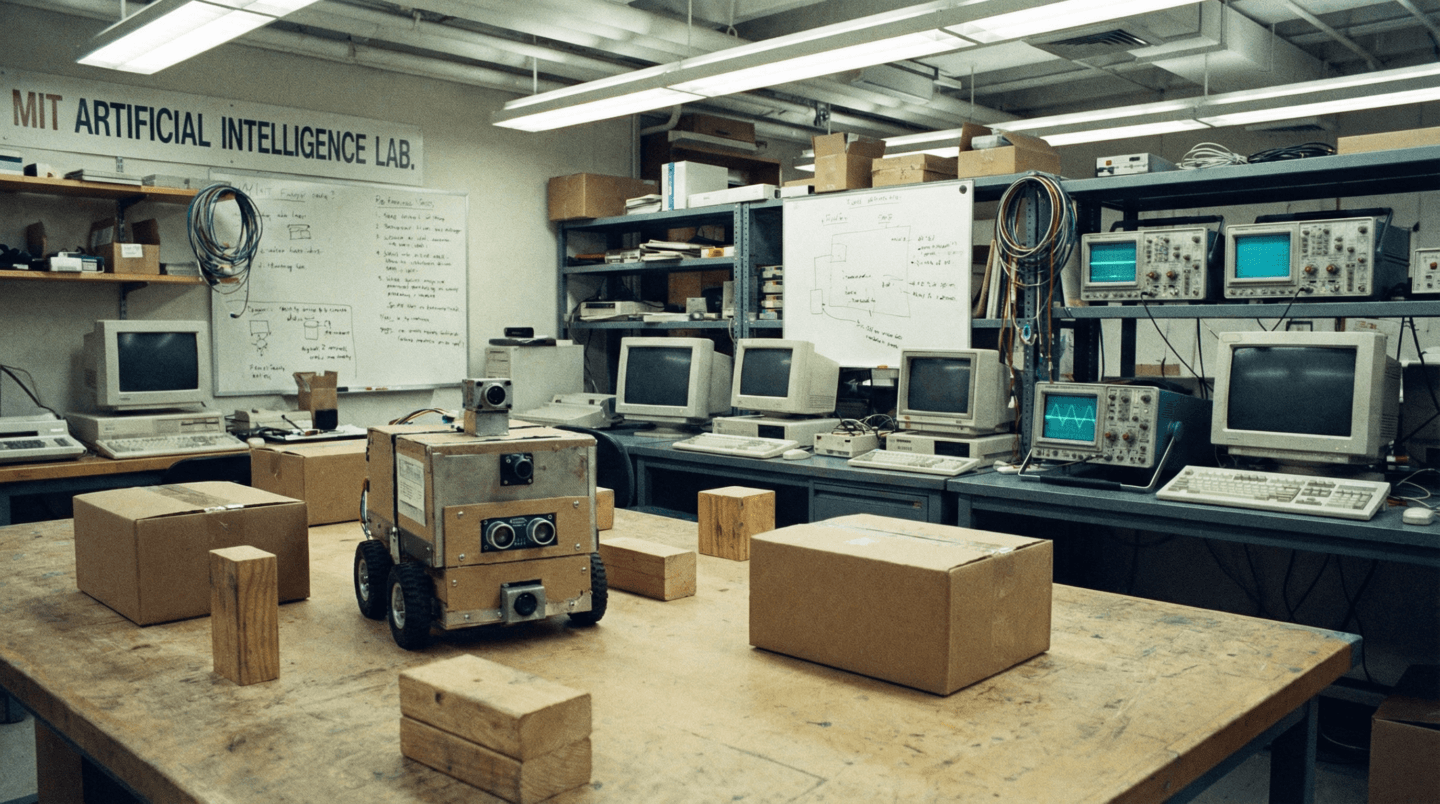

Die Idee ist älter als ChatGPT. Rodney Brooks, Mitgründer von iRobot und früherer Direktor des MIT AI Lab, prägte den Ansatz in den 1980er Jahren. Er argumentierte gegen die damals dominante Vorstellung, Intelligenz sei primär Symbolverarbeitung. Stattdessen entwickelte er die „Subsumption Architecture”, bei der einfache Verhaltensweisen direkt auf Sensordaten reagieren, ohne abstrakte Weltmodelle.

Brooks’ berühmtes Zitat: „The world is its own best model.” Statt die Welt komplett zu simulieren, sollten Roboter direkt mit ihr interagieren und durch diese Interaktion lernen.

Jahrzehnte später erleben wir, wie diese Idee in großem Maßstab umgesetzt wird. Was sich geändert hat: die Rechenleistung, die Sensorik, und vor allem die KI-Modelle, die jetzt leistungsfähig genug sind, um komplexe Zusammenhänge aus Erfahrungen zu extrahieren.

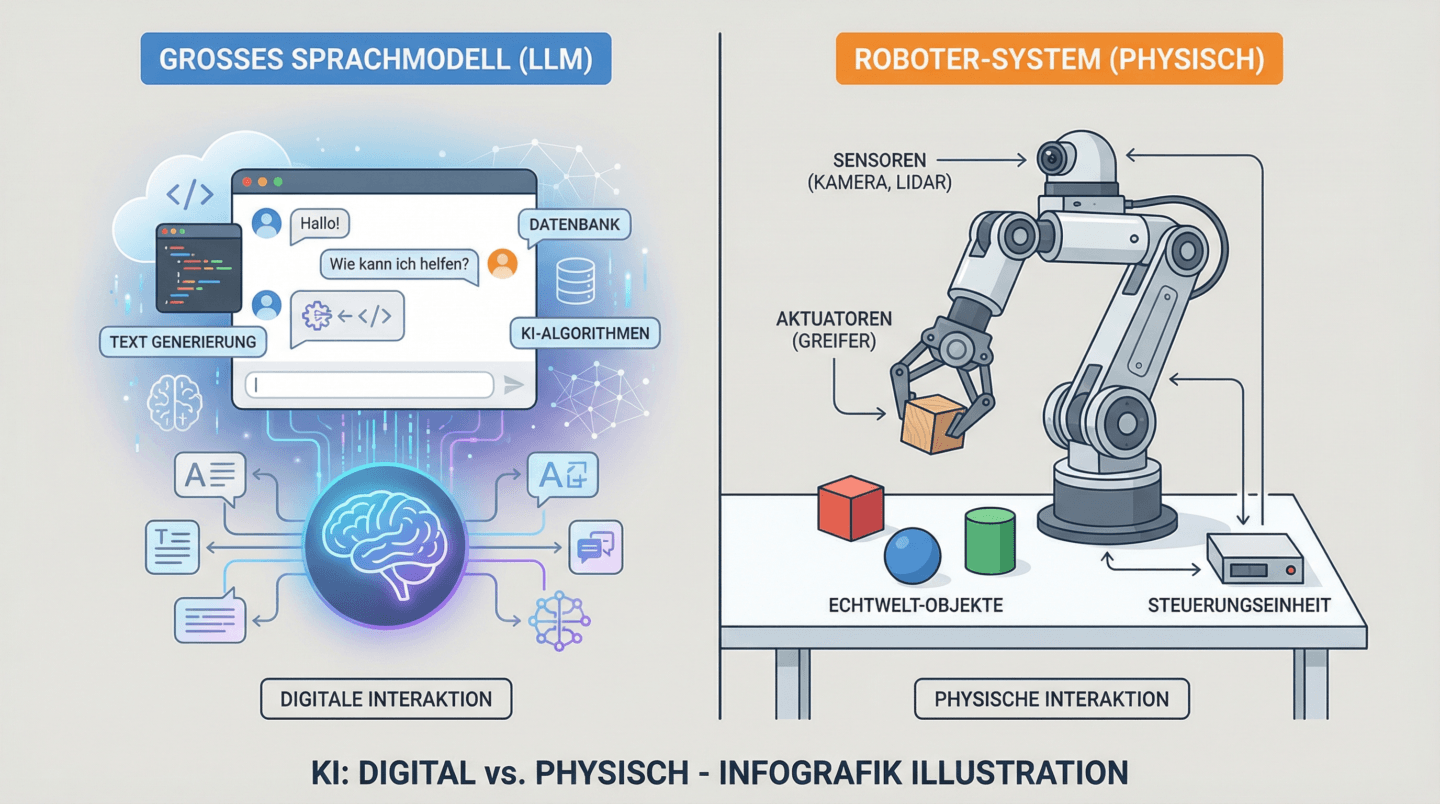

Physical AI vs. Embodied AI

NVIDIA nutzt seit 2024 verstärkt den Begriff „Physical AI”. Was ist der Unterschied? Eigentlich: Nuancen.

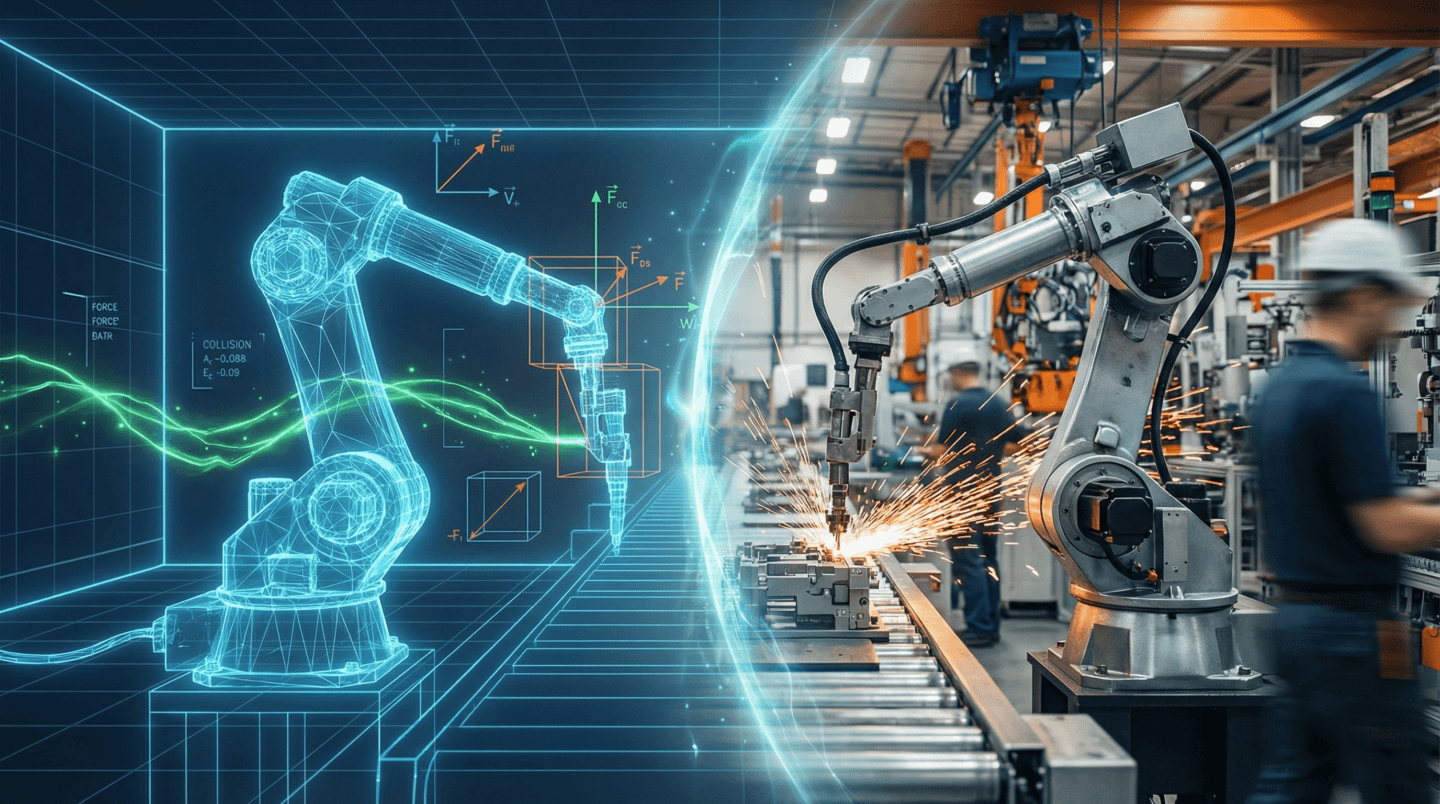

Embodied AI betont den Körper, also die Tatsache, dass die KI in einem Roboter, Fahrzeug oder einer anderen physischen Form existiert. Physical AI ist breiter gefasst und beschreibt KI, die die physikalischen Gesetze der Welt versteht und mit ihr interagiert, ob als Roboter, als autonomes Fahrzeug oder als Simulation einer Fabrik.

In der Praxis werden beide Begriffe oft synonym verwendet. NVIDIA’s Jensen Huang spricht vom „ChatGPT-Moment für Robotik” und meint damit den Durchbruch, bei dem KI-Modelle die physische Welt so gut verstehen, dass sie sinnvoll handeln können.

Die Schlüsselkomponenten

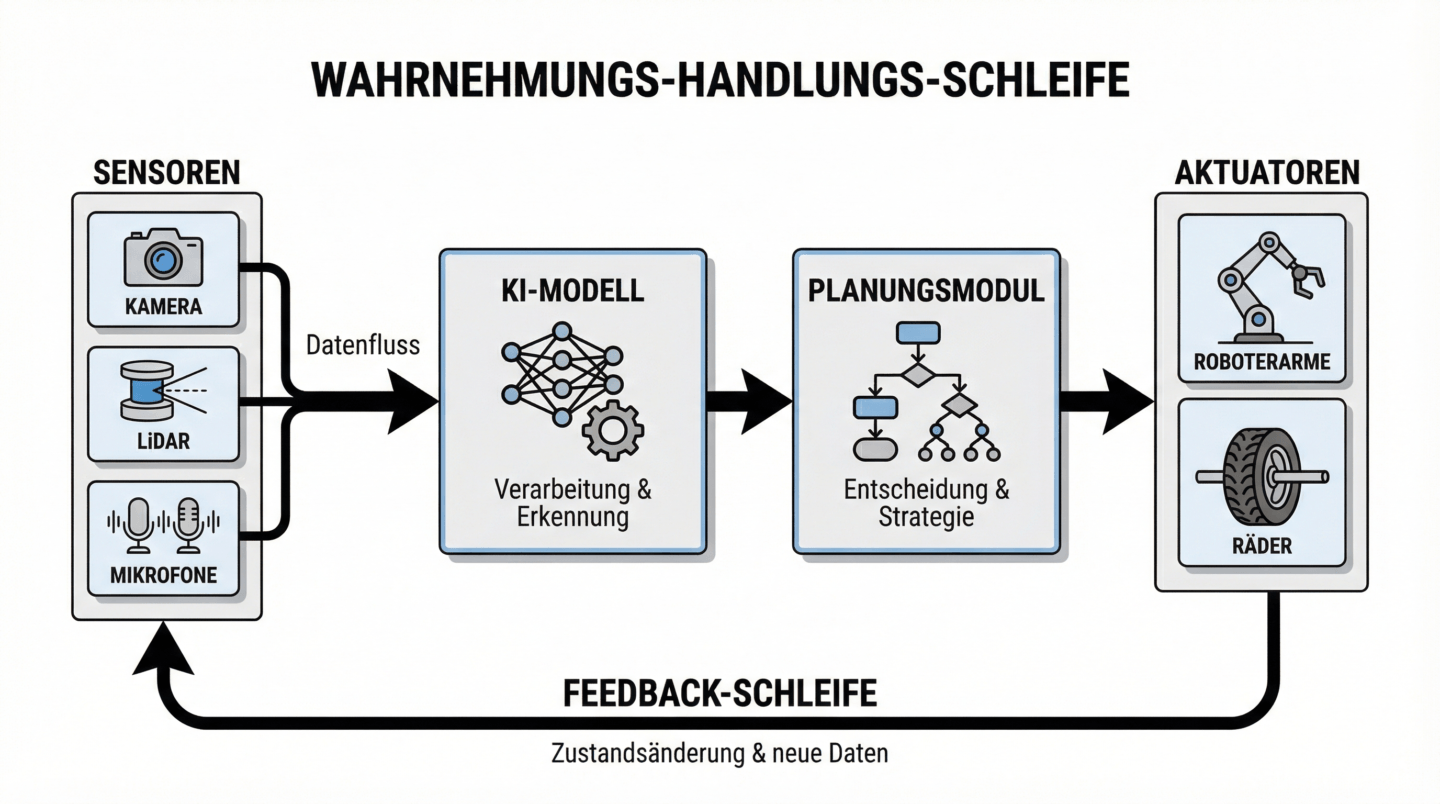

Embodied AI besteht aus mehreren Bausteinen, die zusammenspielen müssen:

Der Perception-Action-Loop ist der Kern: Sensoren nehmen die Umgebung wahr, ein Modell verarbeitet diese Daten und plant eine Aktion, Aktuatoren führen die Aktion aus und das System analysiert das Feedback. Dieser Kreislauf läuft kontinuierlich.

Multimodale Sensorik bedeutet, dass Embodied AI nicht nur sieht, sondern auch hört, fühlt und teilweise sogar riecht. Kameras, Mikrofone, Kraft-Drehmoment-Sensoren, Lidar und mehr liefern gemeinsam ein reiches Bild der Umgebung.

World Models sind KI-Modelle, die verstehen, wie die Welt funktioniert. Sie können vorhersagen, was passiert, wenn ein Objekt geschoben wird, wie sich Flüssigkeiten verhalten, wie Gegenstände interagieren. Diese Modelle werden auf riesigen Mengen von Videos und Simulationsdaten trainiert.

Reinforcement Learning ermöglicht es Robotern, durch Versuch und Irrtum zu lernen. Anders als bei Menschen geht das in Simulation millionenfach schneller, weshalb Simulations-Plattformen wie NVIDIA Isaac Sim so wichtig sind.

Warum das jetzt relevant wird

2025 markierte einen Wendepunkt. Investment in Embodied AI hat sich verfünffacht. Zwei Drittel des US-Risikokapitals für KI-Startups fließen mittlerweile in diesen Bereich. Das hat Gründe.

Erstens: Foundation Models für Robotik entstehen. Covariant stellte 2024 RFM-1 vor. Physical Intelligence veröffentlichte π0.5. Google DeepMind arbeitet an Gemini Robotics. Diese Modelle können auf verschiedene Roboter und Aufgaben angewendet werden, statt für jeden Einsatz neu trainiert werden zu müssen.

Zweitens: Simulations-zu-Realität-Transfer funktioniert endlich zuverlässig. Roboter, die in virtuellen Umgebungen trainiert wurden, können ihre Fähigkeiten in der echten Welt einsetzen, mit weniger Nachtraining als früher nötig war.

Drittens: Die Hardware ist bereit. Humanoide Roboter wie Tesla Optimus, Agility Digit oder der Figure 02 sind keine Forschungsprojekte mehr. Sie stehen in Fabriken und werden in Stückzahlen produziert.

Wo wir heute stehen

Ehrlich gesagt noch am Anfang. Die Fortschritte sind real, aber Embodied AI ist weit davon entfernt, so robust zu sein wie ein Mensch. Ein typischer humanoider Roboter kann kontrollierte Aufgaben in strukturierten Umgebungen ausführen. Eine chaotische Küche oder ein unaufgeräumtes Wohnzimmer bringen ihn schnell an Grenzen.

Was funktioniert: Lagerlogistik, Inspektion, einfache Montageaufgaben, Lieferroboter auf definierten Routen. Was noch nicht funktioniert: wirklich universelle Haushaltsroboter, die jeden beliebigen Gegenstand manipulieren können.

Der Unterschied zwischen einer beeindruckenden Demo und einem robusten Produkt bleibt groß. Aber er schrumpft. Schneller, als die meisten erwartet haben.

XONOID Fazit

Embodied AI ist das, was mich an Robotik fasziniert. Nicht die Mechanik, nicht die Aktuatoren. Sondern die Frage, wie Maschinen lernen können, die physische Welt zu verstehen, nicht nur zu beschreiben.

Die Ironie ist, dass wir Milliarden in LLMs investiert haben, die beeindruckend viel über die Welt „wissen”, aber nichts davon erfahren haben. Jetzt beginnen wir, diesen Mangel zu adressieren.

Die nächsten Jahre werden zeigen, ob die aktuellen Ansätze skalieren. Ob World Models wirklich die fehlende Zutat sind. Ob Reinforcement Learning in der echten Welt so gut funktioniert wie in der Simulation.

Ich bin optimistisch. Nicht weil die Demos beeindruckend sind, die sind sie schon seit Jahren. Sondern weil zum ersten Mal die gesamte Infrastruktur steht: die Modelle, die Simulation, die Hardware, das Kapital. Die Einzelteile waren lange vorhanden. Jetzt beginnen sie, zusammenzuwachsen.